Die Digitalisierung stellt Unternehmen vor große Herausforderungen. Der Umgang mit den Massendaten im Hinblick auf Industrie 4.0 wird zum kritischen Erfolgsfaktor und bestimmt, ob es einem Unternehmen gelingt, Wettbewerbspositionen zu sichern und möglichst weiter auszubauen.

Mit 9 Tipps zur perfekten Datenanalyse

Es ist nicht ausreichend, Daten in großem Umfang zu erheben und auch die Anschaffung modernster Informationstechnologien und Business Intelligence Tools ist keine Garantie dafür, dass mit Hilfe einer geeigneten Datenanalyse aus wertlosem Datenmaterial wertvolle Entscheidungsgrundlagen generiert werden. Der Prozess der Datenanalyse muss im Sinne einer strategischen Ausrichtung vorbereitet und organisatorisch verankert werden, damit die Potentiale der Datenanalyse effektiv genutzt werden können. Zeitdruck und unklare Vorgaben erschweren die Datenanalyse. Mit den im Folgenden dargestellten Tipps können Unternehmen die Datenanalyse optimieren und so die maximalen Informationen aus ihren Datenbeständen extrahieren.

Welches Potential bietet eine perfekte Datenanalyse?

Unternehmen tragen den Wettbewerb zunehmend in der digitalen und nicht mehr in der realen Welt aus. Zu diesem Zweck werden im Zusammenhang mit Big Data Massendaten gesammelt, die ein möglichst exaktes Bild der realen Welt abbilden. Es ist jedoch nicht einfach, diese Daten nicht nur zu erfassen, sondern sie im Anschluss auch so zu analysieren, dass daraus Aussagen abgeleitet werden, die dem Management bei der Entscheidungsfindung helfen. Gelingt es, die in den Daten verborgenen Zusammenhänge, Muster und Kausalitäten zu erkennen, kann dieses Wissen genutzt werden, um die Wettbewerbsposition des Unternehmens zu verbessern. Kundenwünsche können genauer antizipiert werden und eine datengestützte Produktion und Lagerhaltung sowie die Beschleunigung aller Geschäftsprozesse tragen dazu bei, Kosten zu sparen. Im optimalen Fall ist es sogar möglich, datenbasiert Prognosen künftiger Szenarien zu erstellen und somit früher als die Konkurrenz auf Chancen und Risiken zu reagieren.

Obwohl die technologischen Voraussetzungen für die Erfassung, Aufbereitung, Speicherung und Analyse von Massendaten bereits gegeben sind, stoßen die Unternehmen immer noch auf Hindernisse bei der Durchführung der Datenanalyse. Ausgehend von der Überzeugung, dass eine optimalen Datenanalyse zwingend erforderlich ist, lohnt es sich für die Firmen, diesem wichtigen Thema die notwendige Bedeutung und Beachtung einzuräumen. Mit einigen Tipps kann der Prozess der Datenanalyse professionalisiert werden und es wird möglich, die Informationen aus der Datenflut zu filtern und die daraus resultierenden Erkenntnisse in die Entscheidungen einzubringen.

Die Erkenntnis, dass es sich bei der Datenanalyse um eine erfolgskritische Aufgabe handelt, muss sich im gesamten Unternehmen durchsetzen. (#01)

Tipp Nummer 1: Unternehmensweite Sensibilisierung für die Relevanz der Datenanalyse

Die Erkenntnis, dass es sich bei der Datenanalyse um eine erfolgskritische Aufgabe handelt, muss sich im gesamten Unternehmen durchsetzen. Auf allen Ebenen bestimmt der korrekte Umgang mit den Daten die Qualität der Datenanalyse, sodass es wichtig ist, das Management und die Mitarbeiter für dieses Thema zu sensibilisieren. Die Massendaten können nicht mehr mit einfachen Statistikprogrammen ausgewertet werden. Zukunftstrends wie Big Data, das Internet of Things oder Data Mining erfordern eine umfassendere Sicht auf das Thema Datenanalyse. Hinzu kommen steigende Verpflichtungen der Unternehmen in den Bereichen Compliance, Datensicherheit und Datenschutz, die es auch von rechtlicher Seite her notwendig werden lassen, dem Thema Datenanalyse die entsprechende Relevanz einzuräumen.

In vielen Unternehmen ist allerdings noch immer die Meinung verbreitet, dass der Einsatz von Excel-Tools ausreicht, um die oben genannten Anforderungen zu erfüllen. Excel stößt jedoch bei der Verarbeitung von Massendaten aus unstrukturierten und polystrukturierten Quellen schnell an Grenzen und engt somit den Horizont der Datenanalyse in einer Art und Weise ein, die sich als Problem erweist, wenn sich Unternehmen im globalisierten Wettbewerb behaupten müssen. Mit Excel allein ist es schwierig, Massendaten performant zu verarbeiten. Auch das Erstellen von Ad hoc Berichten, die anlass- und themenbezogen über die Standardberichte hinausgehen, ist mit Excel kaum zu bewältigen. Riesige Excel-Tabellen erschweren oder verhindern sogar den Überblick über das bereits vorhandene Datenmaterial. Hinzu kommt die Fehleranfälligkeit der Software, die zu viele manuelle Bearbeitungsschritte und Korrektureingriffe erfordert.

Aus diesem Grund sollte neben der unternehmensweiten Sensibilisierung für das Thema auch die Investition in eine innovative Systemlösung nicht gescheut werden. Mit einer derartigen Software werden Daten einerseits automatisch und somit weniger fehleranfällig erfasst und andererseits auch optimal bereinigt. Im Anschluss an die Datenbereinigung steht dem System ein qualitativ hochwertiger Datenbestand zur Verfügung, der als Basis einer umfassenden Datenanalyse dient. Die modernen Systemlösungen überzeugen mit umfangreichen Funktionalitäten der Datenanalyse und bringen dem Unternehmen deutliche Erkenntnisfortschritte. Die Datenanalyse ist ein kritischer Erfolgsfaktor und darum führt kein Weg daran vorbei, sich mit passenden Business Analytics Tools und einer fortschrittlichen digitalen Technologie möglichst optimal dafür zu rüsten.

Tipp Nummer 2: Auswahl der passenden IT-Lösung für das Unternehmen

Wenn sich Unternehmen über die zur Verfügung stehenden IT-Lösungen am Markt informieren, folgt schnell die ernüchternde Einsicht, dass es nicht die Standard-Lösung gibt, die man einfach erwerben und installieren kann. Es ist ganz entscheidend, vor der Investition den individuellen Bedarf des Unternehmens im Hinblick auf eine passende IT-Technologie zu definieren. Welche Erwartungen haben die verschiedenen Fachabteilungen und welche Informationsbedarfe hat das Management? Auch die Frage, an welchen Stellen Standardsysteme nicht die erforderlichen flexiblen Datenanalysen liefern können und deshalb mit speziellen Tools kombiniert werden müssen, stellt sich in dieser Phase. Leistungsstarke, umfangreiche Business Intelligence Systeme sind beispielsweise für ein unternehmens- oder sogar konzernweites Controlling eine optimale Wahl, können jedoch für andere Fragestellungen überdimensioniert, unflexibel und somit ungeeignet sein.

Dieses Problem tritt insbesondere bei folgenden Anwendungsbereichen der Business Intelligence Tools auf:

- Sondierung von Kundendaten für spezifische Marketingkampagnen

- Auswertung von Messdaten der Smartmeter im Energiesektor

- Analyse von Datenbeständen der Artikel

- Datenanalysen zur Vorbereitung einer Multi-Channel-Strategie im eCommerce

- Bereitstellung von Daten für Compliance-Audits

- Lagerbestandsanalyen

- Messwertanalysen der Forschungs- und Entwicklungsabteilung

Für die obigen Fragestellungen eignen sich Spezial-Tools wesentlich besser. Diese Anwendungen bieten dem User flexiblere Optionen für eine branchen- oder themenspezifische Datenanalyse im Big Data Kontext. In diesen Fällen können Unternehmen zu smarten, flexiblen Anwendungen greifen, die relativ einfach zu implementieren sind und keine hohen Investitionsaufwendungen verursachen. Derartige Lösungen sind besonders für kleine und mittelständische Unternehmen der perfekte Einstieg in den Bereich der Datenanalyse. In großen Unternehmen bevorzugen vor allem Fachabteilungen eine schlanke Software-Lösung für ihre speziellen Fragestellungen. Insgesamt ist es erforderlich, vor einer Investition den genauen Bedarf festzustellen, um die passenden Analyse Tools für das Unternehmen zu finden und den gewünschten Mehrwert, den die damit durchgeführten Datenanalysen erbringen, kosteneffizient zu realisieren.

Tipp Nummer 3: Nutzung der Fachkompetenzen durch Datenanalysen im Self-Service

Die Zeiten, als die Datenanalyse die alleinige Aufgabe der IT-Abteilung war, sind längst vorbei. Es ist ein Merkmal der digitalen Transformation, dass unternehmensweit auf allen Ebenen und in allen Abteilungen Entscheidungen datengestützt getroffen werden. Aus diesem Grund ist es notwendig, die Datenanalysen genau dort vornehmen zu lassen, wo die Fragen auftauchen, also in den Fachabteilungen. Hier stehen Entscheidungen an, müssen Probleme gelöst werden und ist die Fachkompetenz vorhanden, die richtigen Fragen zu formulieren, deren Beantwortung im Rahmen der Datenanalyse die Entscheidungsgrundlagen bilden.

Durch den Einsatz moderner Business Intelligence Tools ist es mittlerweile problemlos möglich, dass auch Mitarbeiter, die lediglich über rudimentäre IT-Kenntnisse verfügen, Datenanalysen im Self-Service durchführen. Moderne Informationstechnologien zeichnen sich durch ein hohes Maß an Benutzerfreundlichkeit aus und können meist nach sehr kurzer Einarbeitungszeit von den Mitarbeitern der Fachabteilungen eigenständig bedient werden. Zum ersten Mal ist es möglich, ohne lange Anfragen im IT-Bereich ad hoc interessante Fragestellungen zu überprüfen und nicht nur das Fachwissen, sondern auch die Erfahrung und Intuition der Mitarbeiter zu nutzen.

Wurden vor nicht allzu langer Zeit spezifische Fragestellungen noch an externe IT-Dienstleister ausgelagert, ist dieser Bereich der Datenanalyse mittlerweile Teil des Tagesgeschäfts. Auch das ist ein entscheidender Schritt zur Beschleunigung von Geschäftsprozessen. Es ist wichtig, die Mitarbeiter der Fachabteilungen bei der Auswahl der Software Tools für die Datenanalyse einzubeziehen und diese hinsichtlich der spezifischen Bedarfe zu befragen.

Generell sollten Analyse Tools, die für den Einsatz im Self-Service geeignet sind, über folgende Attribute verfügen:

- Bedienbarkeit muss intuitiv und einfach sein und sollte keine IT-Kenntnisse voraussetzen

- Datenselektion muss flexibel möglich sein

- Abfragen von Massendaten erfolgen mit hoher Performance

- Möglichkeiten der Datenvisualisierung sollten vorhanden sein

- Unterstützung von Präsentationen durch hohe Reporting-Funktionalität

- Fähigkeit zur einfachen Einbindung unterschiedlichster Datenquellen

- Möglichkeit der flexiblen Kombination von Datenquellen und Vorsystemen

Die unternehmensinterne Durchführung von Datenanalysen ist auch im Hinblick auf die Erfüllung von Anforderungen der Datensicherheit und Compliance einer Auslagerung auf externe IT-Dienstleister vorzuziehen.

Tipp Nummer 4: unternehmensinterne Integration des Bereichs Data Mining

Es ist aus den genannten Gründen darüber hinaus sinnvoll, den Bereich des Data Mining insgesamt direkt im Unternehmen anzusiedeln. Dabei werden die aus den verschiedensten Quellen auf das Unternehmen einströmenden Massendaten mit geeigneten IT-Tools systematisch ausgewertet, um Muster und Querverbindungen aufzuzeigen. Data Mining ist ein interdisziplinäres Verfahren der computergestützten Datenanalyse unter Einsatz von statistischen Verfahren.

Die Analyse großer Datenbestände im Rahmen von Big Data soll zu einer „Knowledge Discovery in Databases“ führen, also die in den Daten verborgenen Informationen identifizieren. Data Mining ist somit der eigentliche Prozess der Datenanalyse, welcher der korrekten Datenerhebung und effizienten Datenbereinigung folgt. Die hohe Relevanz der datengestützten Entscheidungsfindung in Unternehmen bedingt die Notwendigkeit, direkt im Unternehmen Kompetenzen in diesem erfolgskritischen Bereich aufzubauen und diese Aufgaben nicht an externe Dienstleister auszulagern.

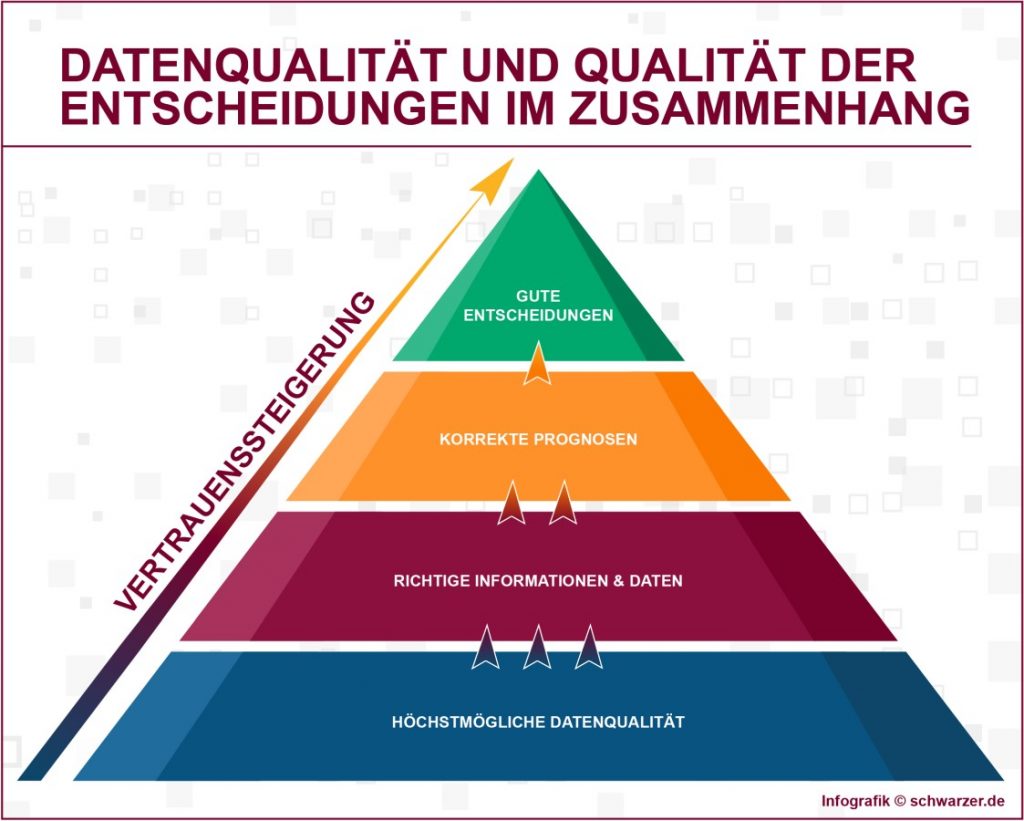

Jedes System kann nur so gute Lösungen generieren, wie der Input es erlaubt. Das gilt selbstverständlich auch für den komplexen Bereich der Datenanalyse. (#03)

Tipp Nummer 5: Sicherstellung einer hohen Datenqualität

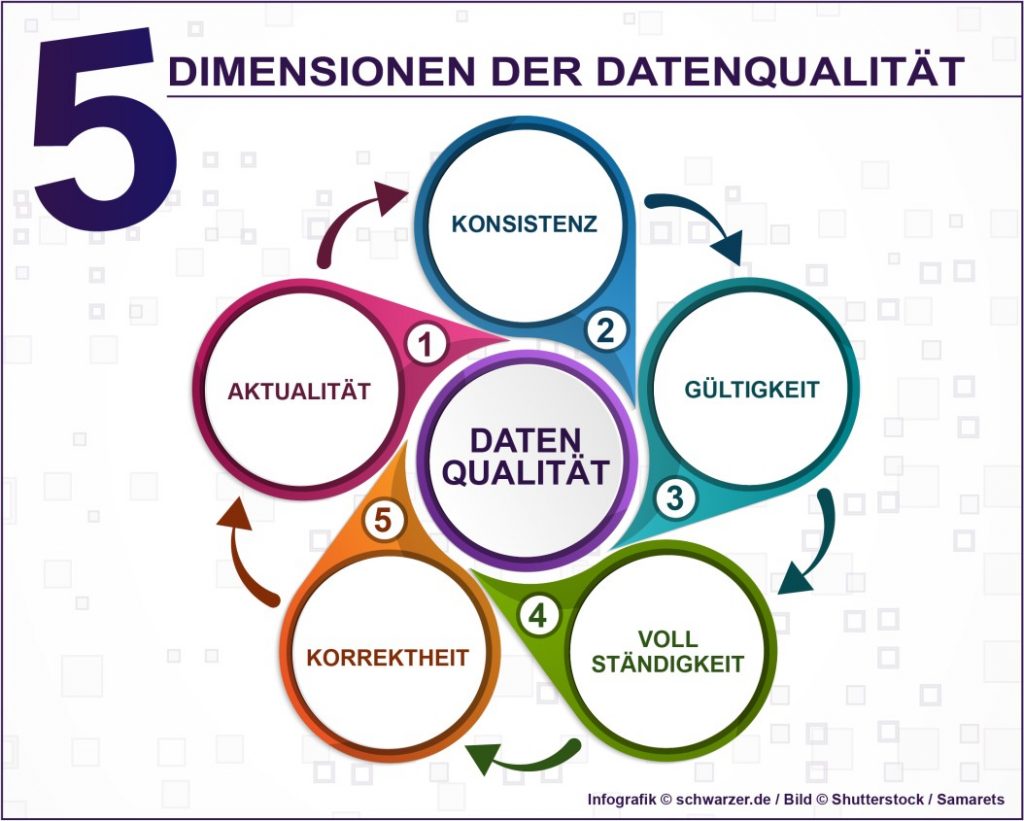

Jedes System kann nur so gute Lösungen generieren, wie der Input es erlaubt. Das gilt selbstverständlich auch für den komplexen Bereich der Datenanalyse. Die Qualität des Datenbestandes determiniert die Ergebnisse der Datenanalyse. Es ist deshalb notwendig, vor der eigentlichen Analyse den Schritt der Datenbereinigung in den Prozess der Datenverarbeitung zu integrieren. Selbst die modernsten und effizientesten Analyse-Tools werden nicht den gewünschten Erkenntnisfortschritt erzielen, wenn die Datenbasis fehlerhaft, unvollständig, nicht aktuell oder nicht valide ist.

Vor der Datenanalyse steht also die Überprüfung und Sicherstellung der Datenqualität. Big Data eröffnet Unternehmen durch die Einbeziehung von Massendaten aus unterschiedlichsten Quellen zwar enorme Potentiale, birgt jedoch gleichzeitig die Gefahr, dass das Unternehmen im Datenmüll erstickt. Nie zuvor standen den Firmen so viele Datenquellen zur Verfügung. Neben den unternehmensinternen Daten sollen auch Sensor- und Geodaten, Daten aus den Sozialen Netzwerken und dem Internet einbezogen werden. Es ist deshalb zunächst wichtig zu definieren, welche Daten überhaupt einen Mehrwert erbringen und somit in die Datenanalyse einbezogen werden sollten.

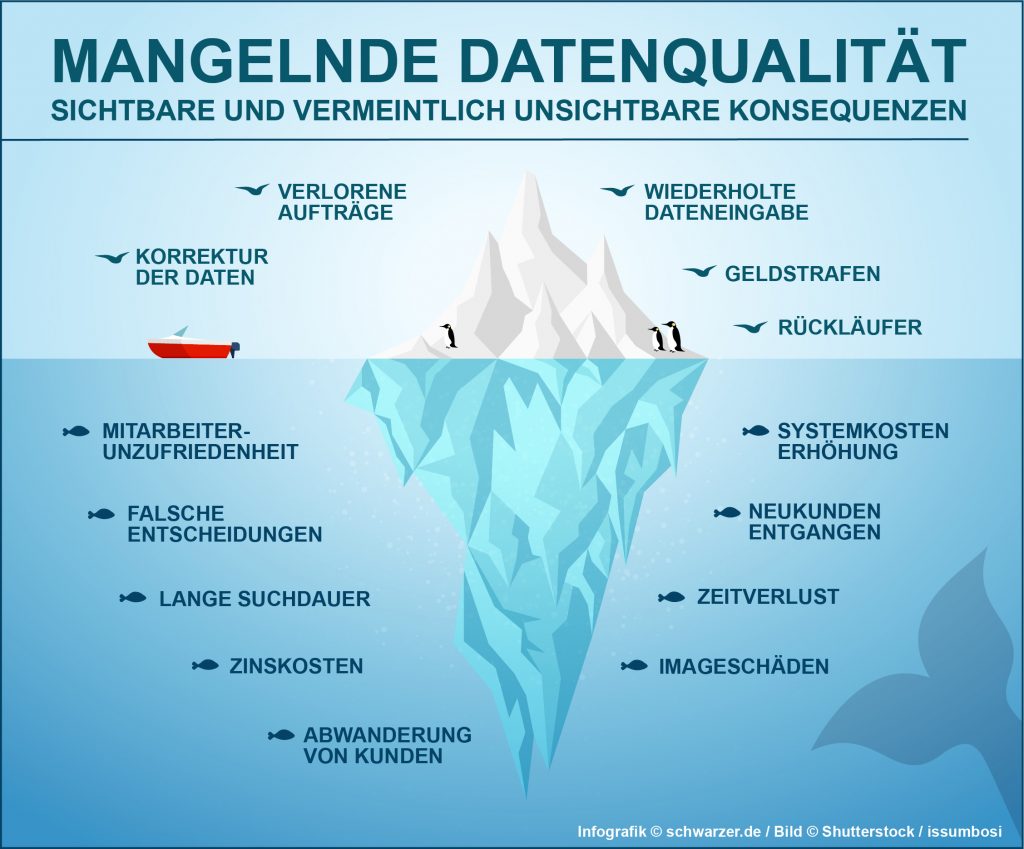

Danach müssen fehlerhafte, redundante, veraltete und unvollständige Datensätze korrigiert oder entfernt werden. Ist beispielsweise die Kundendatei nicht auf dem neuesten Stand, werden Rechnungen zu falschen Adressen geschickt, Lieferungen erreichen nicht ihr Ziel und Werbematerial wird mehrfach versendet. Die negativen Auswirkungen auf die Kundenzufriedenheit führen zur Verschlechterung des Images. Veröffentlichen Kunden ihre schlechten Erfahrungen in den Social Media, multiplizieren sich die negativen Folgen und führen zu einer Bedrohung der Wettbewerbsposition. Um das zu verhindern, ist es nötig, Qualitätskriterien für die Daten festzulegen und auf deren strikte Einhaltung zu achten. Eine wesentliche Maßnahme besteht in der einheitlichen Vergabe von Artikelbezeichnungen und der Vermeidung missverständlicher Abkürzungen. Benutzerfreundliche Eingabemasken und weitgehend automatisierte Prozesse der Datenerfassung tragen ebenfalls zu einer hohen Datenqualität bei. Auch für die Datenbereinigung stehen leistungsfähige Tools zur Verfügung.

Vorgehensweise bei der Sicherstellung der Datenqualität

Bevor die Datenanalyse effizient durchgeführt werden kann, muss die Qualität der Daten in folgenden Bereichen überprüft werden:

- Vollständigkeit

- Einheitlichkeit der Schreibweisen

- Korrektheit der Einträge

- Vorhandensein von Dubletten

- Harmonisierung der Datenformate

Ein wichtiges Kriterium der Datenqualität ist die Vollständigkeit. In diesem Prüfschritt wird kontrolliert, ob alle Datenfelder ausgefüllt sind. Fehlen Werte, werden die Ergebnisse der Datenanalyse verzerrt und es werden falsche Entscheidungsgrundlagen formuliert. Beispielsweise sind Marketingkampagnen nicht durchführbar, wenn im CRM-System ein Datenbestand genutzt werden muss, bei dem von vielen Kunden wichtige Adressdaten fehlen oder nur falsche Adressdaten vorliegen. Auch die Einheitlichkeit der Schreibweisen muss gewährleistet sein, damit sinnvolle Analyseergebnisse erwartet werden können.

Des Weiteren erfolgt ein Check der Daten auf Korrektheit. Zahlendreher müssen eliminiert werden. Auch hierfür gibt es automatisierte Anwendungen, die beispielsweise die Richtigkeit der Postleitzahlen überprüfen. Es ist darüber hinaus wichtig, Dubletten zu identifizieren und zu entfernen, denn auch diese doppelten Einträge verzerren die Ergebnisse der Datenanalyse. Wird nicht strikt auf eine einheitliche Artikelbezeichnung geachtet, kann es vorkommen, dass ein Artikel nicht gefunden wird und deshalb ein neuer Datensatz, eine Dublette, angelegt wird.

Doppelt angelegte Kunden-Accounts führen ebenfalls zu Irritationen, wenn ein Kunde mehrfach das gleiche Angebot erhält, weil er unter verschiedenen Namensschreibweisen im System gespeichert ist. Ein letzter Bereich, der im Rahmen der Datenbereinigung betrachtet wird, ist die Harmonisierung der Datenformate. Nicht einheitliche Datumsformate führen beispielsweise zu fehlerhaften Auswertungen. Aus diesem Grund ist es wichtig, das Datenformat einmal einheitlich und korrekt zu definieren, damit die Datenanalyse valide Ergebnisse erbringt.

Die Überprüfung von Plausibilitätskriterien ist ebenfalls sehr wichtig, damit falsche Analyseergebnisse und daraus resultierende Fehlentscheidungen vermieden werden. (#04)

Tipp Nummer 6: Überprüfung der Plausibilität des Datenbestands

Die Überprüfung von Plausibilitätskriterien ist ebenfalls sehr wichtig, damit falsche Analyseergebnisse und daraus resultierende Fehlentscheidungen vermieden werden. Meist werden die Daten des unternehmensinternen ERP-Systems verwendet, um die Datenanalyse durchzuführen. Mit diesen Werten sollte eine Kennzahl ermittelt werden, die leicht überprüft werden kann, wie beispielsweise die gesamten Monatsumsätze. Im nächsten Schritt wird dann diese Zahl mit dem im ERP-System aggregierten Wert verglichen. Wird dabei eine Differenz festgestellt, liegt die Vermutung nahe, dass der extrahierte Datenbestand den Originaldatenbestand des ERP-Systems nicht korrekt abbildet.

Um derartige Diskrepanzen zu vermeiden, werden automatisierte Plausibilitäts- und Vollständigkeitsüberprüfungen durchgeführt. Diese erleichtern mit Warnfunktionen bereits bei der Eingabe der Daten die Vermeidung von Fehlern. Ein Beispiel sind Hinweise darauf, dass Datumsangaben nicht plausibel sind, weil ein Belegdatum nicht in der Buchungsperiode liegt. Ein anderes Beispiel betrifft Marketingkampagnen. Sollen im Rahmen einer Direct-Mailing-Aktion Serienbriefe verschickt werden, muss darauf geachtet werden, dass alle Adressen vollständig sind. Der Hinweis, die Anrede Frau oder Herr zu wählen, schützt vor peinlichen Irrtümern und der Verärgerung von Kunden.

Konsequenzen einer mangelnden Datenqualität

Wenn nicht bereits vor der eigentlichen Datenanalyse auf eine hohe Datenqualität geachtet wird, kann dies weitreichende Konsequenzen nach sich ziehen. Offensichtliche Folgen sind beispielsweise verärgerte Kunden, Geldstrafen und die Notwendigkeit der Datenkorrektur. Es sind jedoch auch indirekte Folgen wie das Abwandern der Kunden, eine sinkende Mitarbeitermotivation oder Fehlentscheidungen zu beachten. Nicht alle Folgen einer unzureichenden Datenqualität sind quantifizierbar, aber besonders die nicht-quantifizierbaren Effekte können die künftige Entwicklung des Unternehmens sehr negativ beeinflussen.

Welche Anlässe sollten zur Überprüfung der Datenqualität genutzt werden?

Jedes Datenintegrations- und Migrationsprojekt sollte zum Anlass für eine Überprüfung der Datenqualität und eine Datenbereinigung genommen werden. Werden Datensätze aus unterschiedlichen IT-Systemen zusammengeführt, weisen diese in den meisten Fällen auch differierende Datenstrukturen auf. Das stellt das Zielsystem vor große Herausforderungen. Damit das Migrationsprojekt als erfolgreich eingestuft werden kann, muss von Anfang an auf die Qualität, Konsistenz und Transparenz der neu entstandenen Datenbasis geachtet werden. Können diese Bedingungen nicht erfüllt werden, ist damit zu rechnen, dass die anschließenden Datenanalysen keine korrekten Ergebnisse ergeben und somit das Ableiten von Handlungsempfehlungen unmöglich wird.

Die neue Applikation könnte also nicht den intendierten Mehrwert erreichen. Es ist deshalb unbedingt empfehlenswert, jedes Mal, wenn neue Quelldaten in das eigene System integriert werden sollen, diese zunächst im Hinblick auf zuvor definierte Qualitätskriterien zu beurteilen und gegebenenfalls zu bereinigen. Können sich die Entscheider auf die Qualität der Datenbasis verlassen, steigt das Vertrauen in die Entscheidungsgrundlagen, was besonders in Krisensituationen ein schnelles Eingreifen ermöglicht.

Damit die Datenanalyse mit den modernen Business Intelligence Tools intentionsgemäß durchgeführt werden kann, sollte eine organisatorische Verankerung des Datenmanagements für einen adäquaten Rahmen sorgen. (#05)

Tipp Nummer 7: Verbesserung des Analyseprozesses durch das Etablieren von Methoden und Routinen

Damit die Datenanalyse mit den modernen Business Intelligence Tools intentionsgemäß durchgeführt werden kann, sollte eine organisatorische Verankerung des Datenmanagements für einen adäquaten Rahmen sorgen. Alle Datenanalysen, die regelmäßig durchgeführt werden müssen, werden zu diesem Zweck als hocheffiziente Routinen etabliert. Eine vorherige genaue Strukturierung der Prozesse führt auch im Bereich des Datenmanagements zu beschleunigten und optimierten Prozessabläufen und schaltet potentielle Fehlerquellen von Anfang an aus.

In diesem Zusammenhang sollten auch die Verantwortlichkeiten eindeutig geklärt werden. Mitarbeiter, denen die Aufgaben der Datenerfassung, Datenbereinigung und Datenanalyse übertragen werden, benötigen die entsprechenden Kompetenzen und sollten durch regelmäßige Schulungen immer wieder auf den neuesten Kenntnisstand gebracht werden. Fachlich kompetente Data Owner definieren außerdem Qualitätskriterien für die Daten und sind auch verantwortlich für die Sicherstellung der Datenqualität. Power User, die über besondere Kenntnisse im Bereich der Datenanalyse verfügen, werden beauftragt, Ad hoc Datenanalysen zu besonderen Themen durchzuführen. Mit diesen Ad hoc Analysen werden die Standardberichte ergänzt. Sie werden besonders dann erstellt, wenn ein dringlicher Handlungsbedarf schnelles Eingreifen erfordert und dafür datenbasierte Entscheidungshilfen benötigt werden.

Eine bewährte Möglichkeit der organisatorischen Integration der Datenanalyse ist die Ansiedelung als zentraler „Shared Service“, der als Dienstleister für die Fachabteilungen fungiert. Gleichartige Prozesse aus den verschiedenen Fachabteilungen werden dafür zentral zusammengefasst. Dies ist im Prinzip eine Form des internen Outsourcing von Aufgaben, wobei die Vorteile eines externen Dienstleisters mit der Nutzung von Kenntnissen interner Mitarbeiter verbunden werden. Darüber hinaus soll es dennoch möglich sein, dass auch innerhalb der Fachabteilungen Datenanalysen zu spezifischen Fragestellungen im Self-Service durchgeführt werden.

Tipp Nummer 8: Sicherstellung eines hohen Maßes an Flexibilität

Die Digitalisierung der Unternehmen dient dem Ziel, dass sich die Firmen in einer zunehmend dynamischen Umwelt optimal behaupten können. Je besser es gelingt, aus den Massendaten die entscheidenden Informationen zu extrahieren, desto genauer kann auf Kundenwünsche eingegangen werden. Außerdem werden Risiken schneller erkannt und auch Chancen eher identifiziert. Schnelles Reagieren und besser noch antizipatives Agieren verschafft dem Unternehmen Wettbewerbsvorteile. Fortschrittliche Business Analytics können nicht nur die Vergangenheit erklären und die Gegenwart beschreiben, sondern ermöglichen das Aufstellen datenbasierter Prognosemodelle. Das bedeutet wiederum, dass die Entscheider in den Unternehmen nicht mehr darauf angewiesen sind, das richtige Bauchgefühl zu entwickeln, sondern auf Basis von Informationen die wirtschaftliche Situation des eigenen Unternehmens, der Konkurrenten und des gesellschaftlichen Umfelds einschätzen. Darauf aufbauend werden Maßnahmen ergriffen, die das Unternehmen in die gewünschte Richtung lenken.

Um diese Ziele zu erreichen, muss jedoch bei der Auswahl der Analytic Tools darauf geachtet werden, dass diese sich auch an die dynamischen Umweltbedingungen und wechselnde Anforderungen anpassen lassen und außerdem in der Anwendung skalierbar sind. Eine ideale Vorgehensweise besteht darin, eine dringend benötigte Anwendung zunächst in einem Fachbereich zu implementieren. Davon ausgehend wird diese Anwendung nach und nach auf andere Fachbereiche ausgeweitet und unternehmensindividuell angepasst, indem sinnvolle Vertiefungen und Erweiterungen vorgenommen werden. Auf diese Weise wird schnell ein Mehrwert der IT-Investition erreicht und darüber hinaus wird das Entstehen von isolierten Insellösungen im Unternehmen verhindert.

Es ist außerdem sinnvoll, darauf zu achten, dass eine prinzipielle Offenheit im Hinblick auf die implementierten Informationsprozesse besteht. Auch die Informationsprozesse müssen wie alle anderen Geschäftsprozesse immer wieder hinterfragt, optimiert und selbstverständlich an veränderte fachliche Anforderungen oder neue organisatorische Rahmenbedingungen angepasst werden. Die Datenanalyse sollte nicht als starres System verstanden werden, sondern eine freie Datenexploration durch die Möglichkeit einer schnellen und intuitiven Kombination verschiedener Datensegmente erlauben. Die Kombination von demografischen mit geografischen Daten kann beispielsweise zur Erkennung unerwarteter Zusammenhänge führen und neue Möglichkeiten der Marktbearbeitungen eröffnen.

Die Datenanalyse gewinnt an Aussagekraft, wenn mit automatisierten Visualisierungsoptionen, die auf Basis von Best Practise-Empfehlungen generiert wurden, die Ergebnisse der Analyse anschaulich dargestellt werden. (#06)

Tipp Nummer 9: Visualisierung verbessert das Verständnis der Analyseergebnisse

Die Datenanalyse gewinnt an Aussagekraft, wenn mit automatisierten Visualisierungsoptionen, die auf Basis von Best Practise-Empfehlungen generiert wurden, die Ergebnisse der Analyse anschaulich dargestellt werden. Damit wird das Verständnis „auf einen Blick“ ermöglicht und die Informationen können schnell genutzt werden. Visualisierungen erleichtern auch das Verständnis, wenn fachbereichsübergreifend in Teams zusammengearbeitet wird. Lange Erklärungen entfallen und die Teammitglieder erreichen schneller einen gemeinsamen Informations-Level. Linien-, Balken- und Tortendiagramme verdeutlichen Zusammenhänge und Kartendiagramme geben wichtige geografische Informationen. Mit interaktiven Diagrammen wird es sogar möglich, die Analyseprozesse im Sinne eines Dialoges ablaufen zu lassen und damit den Erkenntniswert zu erhöhen. Vorlagen erleichtern die Auswahl der passenden Darstellungsform und tragen zur Beschleunigung der Datenanalyse bei.

Datenanalysen unterstützen eine zukunftsfähige Ausrichtung der Unternehmensentwicklung

Die Datenanalyse gehört mittlerweile in jedem Fachbereich zum Tagesgeschäft und dieser Trend wird sich im Zuge der weiteren digitalen Transformation noch weiter verstärken. Es werden immer schneller riesige Datenmengen erzeugt und Unternehmen beziehen diese Informationen in alle Geschäftsprozesse ein. Big Data Technologien ermöglichen die gezielte Analyse von Massendaten und generieren Entscheidungsgrundlagen. Benutzerfreundliche Business Intelligence Tools führen dazu, dass die Datenanalysen auch von Nutzern durchgeführt werden können, die nicht über umfangreiche Programmierkenntnisse verfügen. Datenanalysen und -visualisierungen werden von den Fachabteilungen flexibel im Self-Service durchgeführt. Besonders die Erstellung von Ad hoc Berichten erfolgt dort, wo die Fragestellungen anfallen, sodass der zeit- und kostenintensive Umweg über die IT-Abteilung entfällt. In der IT-Abteilung werden Kapazitäten frei, um sich mit der Digitalisierung des Unternehmens zu beschäftigen und für die Bereitstellung der nötigen Infrastruktur zu sorgen.

Die genannten Entwicklungen führen dazu, das Prozesse im Unternehmen beschleunigt und Fehlentscheidungen verhindert werden, wenn die zugrunde liegende Datenbasis die entsprechenden Qualitätskriterien erfüllt. Die Datenqualität wird zum Engpassfaktor, denn die Analyseergebnisse sind nur zutreffend und verlässlich, wenn der Dateninput dies erlaubt. Aus diesem Grund sollte vor der eigentlichen Datenanalyse die Datenbereinigung erfolgen, um im Sinne eines iterativen Prozesses den Datenbestand kontinuierlich zu verbessern. Im Anschluss an die Analyse sorgt eine geeignete Visualisierung dafür, dass aus den Entscheidungsgrundlagen schnell Aktivitäten abgeleitet werden und die Kommunikation innerhalb des Unternehmens allgemein verbessert und gestärkt wird.

Es ist somit unbestreitbar, dass die Datenanalyse einen hohen Stellenwert im Unternehmen beansprucht. Umso wichtiger ist es, darauf zu achten, Fehler bei der Datenanalyse zu vermeiden. Welche Stolpersteine auf dem Weg zur perfekten Datenanalyse lauern und wie diese erkannt und umgangen werden, ist Thema eines weiteren Artikels.

Bildnachweis:©Shutterstock-Titelbild: Pressmaster -#01: Rocketclips, Inc. -#02: Rawpixel.com -#03: alphaspirit -#04: ranjith ravindran -#05: Who is Danny -#06: ShutterOK _