Die neue Version des Chat-GPT-Modells von OpenAI ist endlich da und bietet neue Funktionen, die das Modell noch leistungsfähiger machen. Eines der beeindruckendsten Merkmale ist die Fähigkeit, Bilder zu verstehen und in den Antwortprozess zu integrieren. Diese Integration von Bildern ermöglicht es dem Modell, noch genauere und präzisere Antworten zu liefern und eröffnet neue Anwendungsbereiche in verschiedenen Branchen.

GPT-4 ermöglicht Bildinterpretation

Die Welt in Hühnchen: Eine Herausforderung für jede KI. (Foto: Twitter / Bryan Druzin)

Die Veröffentlichung von GPT-4 durch OpenAI am 14.03.2023 hat nicht nur Begeisterung ausgelöst. Obwohl das neue Modell die Leistungsfähigkeit von Chatbots weiter verbessert hat, ist es nur für zahlende Kunden oder Benutzer von Bing verfügbar. Viele Beobachter hatten gehofft, dass GPT-4 für jeden zugänglich sein würde, doch dieser Wunsch wurde nicht erfüllt.

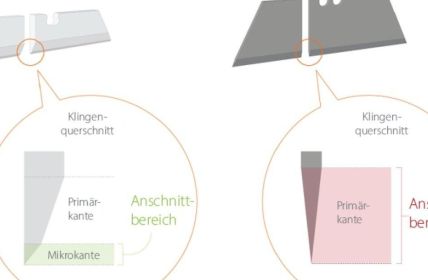

Die Zukunft der Künstlichen Intelligenz wird durch GPT-4 neu definiert. Das Modell ist nicht mehr auf die Verarbeitung von Texten beschränkt, sondern kann auch Bilder verstehen und analysieren. Dadurch ist GPT-4 zu einem multimodalen Modell geworden, das auf verschiedenen Datentypen trainiert wurde. Die Kombination von Informationen aus Text und Bildern eröffnet somit völlig neue Möglichkeiten, die die bisherigen Grenzen sprengt.

OpenAI bringt mit dem Meme der Weltkarte aus Hühnchen eine humorvolle Idee ins Spiel, um die Schwierigkeiten aufzuzeigen, die bei der Verarbeitung von visuellen Informationen durch Künstliche Intelligenz entstehen können. Die ungewöhnliche Art, eine Weltkarte darzustellen, erfordert ein hohes Maß an Kreativität und Vorstellungskraft, um diese Idee umzusetzen.

Das neue KI-Modell zeigt seine Stärken insbesondere bei der Interpretation von komplexen Infografiken. Es ist in der Lage, die Zahlen und Daten in einer Infografik zu erfassen und miteinander zu verknüpfen, um eine Bedeutung abzuleiten. Damit eignet es sich hervorragend, um komplexe Sachverhalte wie Statistiken oder Diagramme in Geschäftsberichten oder wissenschaftlichen Papers einfach und verständlich zu erklären.

GPT-4 ermöglicht Fortschritte in der Mathematik.

Um den Fortschritt von GPT-4 in der Mathematik und anderen Bereichen zu demonstrieren, hat OpenAI eine Liste von menschlichen Prüfungen zusammengestellt, die das Leistungsniveau des neuen Modells gegenüber dem Vorgänger GPT-3.5 vergleichen. Bei einer simulierten Anwaltsprüfung konnte GPT-4 ein beeindruckendes Ergebnis erzielen und erreichte ein ähnliches Niveau wie die besten zehn Prozent menschlicher Antwortgeber, während die alte Version zu den untersten zehn Prozent gehörte.

Eine der größten Verbesserungen, die GPT-4 im Vergleich zu seinem Vorgänger aufweist, ist im Bereich der Mathematik zu finden. Insbesondere in Bezug auf komplexe mathematische Probleme konnte das neue Modell bedeutende Fortschritte erzielen. Allerdings zeigt die Tatsache, dass es bei einer Mathematikprüfung, die von Schulabgängern abgelegt wird, schlecht abschneidet, dass es immer noch Einschränkungen gibt.

Durch das Training von GPT-4 mit korrekten und falschen Antworten auf mathematische Fragen hat OpenAI das Modell in der Handhabung von Zahlen und mathematischen Konzepten verbessert. Dies dürfte sich positiv auf die Anwendung von GPT-4 in verschiedenen Bereichen, wie zum Beispiel der Datenanalyse, auswirken.

Die verbesserte Version des GPT-4 Sprachmodells zeigt signifikante Fortschritte bei der Beantwortung von Fragen, die zuvor eine Herausforderung für künstliche Intelligenz darstellten. Beispielsweise kann das Modell nun die Antwort auf eine Frage wie „Annas Mutter hat drei Töchter: Maria und Ida ? und wie heißt die dritte?“ korrekt liefern, was in der Vergangenheit schwierig gewesen sein könnte. Dies ist ein bedeutender Fortschritt in der natürlichen Sprachverarbeitung und zeigt, dass KI-Systeme immer präziser und genauer werden.

Ein weiterer wichtiger Faktor bei der Verwendung von GPT-4 ist der Kontext, in dem es eingesetzt wird. Das Modell kann nur so gut wie die Daten sein, auf denen es trainiert wurde. Wenn der Kontext nicht angemessen berücksichtigt wird, besteht die Möglichkeit, dass GPT-4 falsche oder ungenaue Antworten gibt.

Mängel in Multimodalität: Huggingface-Gründer Thomas Wolf berichtet

In einem LinkedIn-Post hat Thomas Wolf, Gründer von Huggingface, einem Unternehmen für Open-Source-Sprachmodelle, die positiven Ergebnisse von standardisierten Tests gepriesen. Er hat jedoch auch seine Enttäuschung über das Niveau der Multimodalität zum Ausdruck gebracht, das nicht den Erwartungen entsprochen hat. Obwohl OpenAI von einem multimodalen Modell gesprochen hatte, das in der Lage sein sollte, Bilder oder sogar Videos zu erzeugen, hat sich gezeigt, dass das Modell noch nicht in der Lage ist, diesen Anforderungen gerecht zu werden.

Obwohl GPT-4 als „multimodal“ bezeichnet werden kann, da es mehrere Arten von Daten verarbeiten kann, ist es im Vergleich zu anderen KI-Modellen, die diese Bezeichnung tragen, eher einfach gestrickt. Thomas Wolf, der Gründer von Huggingface, kritisierte das Modell auch für seine begrenzte Fähigkeit, visuelle und andere Arten von Daten zu verarbeiten. Darüber hinaus kritisierte er den technischen Bericht von OpenAI, der wichtige Informationen zum Training, Modell und zur Rechenleistung ausließ.

Die Erwartungen an das kommende GPT-4-Modell waren hoch, und viele Experten und Enthusiasten waren davon überzeugt, dass das Modell dank seiner erweiterten Parameterzahl und Leistungsfähigkeit bahnbrechende Fortschritte in der künstlichen Intelligenz erzielen würde. Doch der CEO von OpenAI, Sam Altmann, hat kürzlich klargestellt, dass die Gerüchte um das Modell übertrieben sind.

Wissenschaftler sind daran interessiert zu erfahren, welche Ressourcen erforderlich waren, um GPT-4 zu trainieren und welche Rolle diese bei der hervorragenden Leistung des Modells gespielt haben. Eine solche Information könnte auch helfen, besser zu verstehen, wie KI-Modelle in Zukunft verbessert werden können.

Keine Kommentare

Mit der Einführung von GPT-4 durch OpenAI betreten wir ein neues Zeitalter der künstlichen Intelligenz, das zweifellos beeindruckende Fortschritte in der Leistungsfähigkeit von KI-Modellen markiert. Die Integration von Bildverarbeitungsfähigkeiten eröffnet ein Panorama neuer Anwendungsmöglichkeiten, von der Verbesserung der Genauigkeit in der Antwortfindung bis hin zum Erschließen unerforschter Branchen. Diese Entwicklung unterstreicht die bemerkenswerte Evolution von KI-Systemen hin zu einer mehr sensorischen und integrativen Intelligenz.

Besonders faszinierend finde ich die Fähigkeit von GPT-4, komplexe Infografiken zu interpretieren, was das Potenzial hat, die Art und Weise, wie wir Informationen konsumieren und verstehen, grundlegend zu verändern.